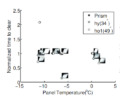

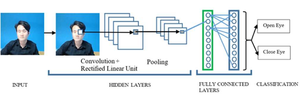

أحد الأسباب الرئيسية لحوادث الطرق التي تؤدي إلى إصابات ووفيات هو نعاس السائقين. في هذه الدراسة، تم تطوير تتبع العين باستخدام نظام جديد قائم على إنترنت الأشياء (IoT) مفتوح المصدر. قامت هذه الدراسة بتقييم ثلاث خوارزميات للتعرف على عين السائق ليتم دمجها في الحل مفتوح المصدر لإيقاظ السائقين عندما يبدأون في الانطلاق: 1) الشبكة العصبية التلافيفية (CNN) مع Haar Cascade، 2) 68 نقطة معالم الوجه و3) اكتشاف النظرة في ثلاثة أوضاع مختلفة للوجه لظروف القيادة ليلاً ونهارًا بالإضافة إلى النظارات وبدونها. يتم اختبار كل مجموعة من هذه العوامل 100 مرة. يتم اختيار أفضل خوارزمية بناءً على أعداد الاكتشافات الصحيحة ثم يتم اختبار هذه الخوارزمية مرة أخرى بناءً على الضوء (ليلاً ونهارًا)، وزاوية الوجه (يسارًا ويمينًا ووسطًا)، وزاوية الكاميرا (يسارًا ويمينًا)، و نظارات (تشغيل وإيقاف) للكشف عن العيون الوامضة والمغمضة. وأظهرت النتائج أن الخوارزمية الأكثر دقة لكشف عيون السائق هي CNN مع خوارزمية Haar Cascade بدقة 94%. ويمكن للنظام اكتشاف حالة عيون السائقين أثناء القيادة، وإذا أغلق السائقون أعينهم لفترة أطول من ثانيتين، يصدر تنبيهًا لإيقاظ السائق وتجنب وقوع الحادث. يتكلف النظام مفتوح المصدر المقترح حوالي 100 دولار أمريكي ويمكن نشره على نطاق واسع للمساعدة في تقليل حوادث الطرق في جميع أنحاء العالم.

- كود مجاني ومفتوح المصدر https://github.com/wissarutkong/cnn_eyedetection

الكلمات الدالة

أنظر أيضا

- OS Computer Vision لإعادة التدوير الموزع والتصنيع الإضافي

- تطبيقات رؤية الكمبيوتر الأخرى لنظام التشغيل